DESARROLLO CON SLEUTH KIT

Y AUTOPSY

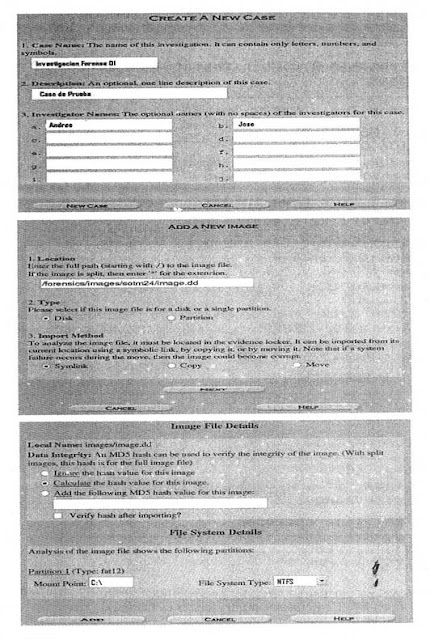

1.- Imagen de datos.

Suministrada junto al marco circunstancial del caso.

2.-Verificación d la integridad de la imagen.

Se realizo la verificación de la integridad del archivo comprimido que tenia l imagen original; sin embargo, dado que el compendio criptográfico de la fuente original no fue suministrado, no fue posible validar la integridad de la imagen con respecto a su fuente

3.-Creación de una copia de la imagen suministrada.

Se hizo una copia (imagen-copy) de la imagen original (image).

4.-Aseguramiento de la imagen suministrada.

El archivo original de imagen (el archivo comprimido) fue almacenado en un sitio seguro.

5.-Revisión de antivirus y verificación de la integridad de la copia de la imagen.

Como no se contaba con ningún programa de antivirus para Linux, fue necesario realizar este proceso en un sistema operativo Windows, usando una proyección de image-copy sobre un disco flexible de 3 ½ haciendo uso del comando:

*dd if/home/diego/FORENSICS/caso-paper/image of=/devf1oppy

Luego de comprobar la ausencia de virus se realizo la verificación del compendio criptográfico de los dos archivos

6.-Identificación de las participaciones actuales y anteriores (las que sea posible recuperar)

Se utilizo el comando mmls para descubrir las participaciones en la imagen, pero el resultado indico que solamente avía una sola participación

7.-Detección de información entre los espacios entre los participantes

Debido a los resultados del paso anterior, eta actividad fue omitida.

8.-Detección de HPA

Dado que se trata de la imagen de un floppy, este paso no aplica

9.-Identificación del sistema de archivos.

Se procede a revisas el sistema de archivos de la imagen lo anterior se logra desde la pantalla central del host, por medio del botón details-filesystem, que despliega la misma información que el comando fsstat.

10.-Recuperación de archivos borrados

En autopsy, en la pantalla del host se selecciona analyse-file analysis, para visualizar todos los archivos contenidos en la imagen incluyendo los que han sido borrados y que fue capas de recuperar.

11-Recuperación de información escondida.

A través del uso de autopsy (data unit-allocationlist) se buscaron los sectores asignados sin metadatos (sectores perdidos) con base en la revisión del primer sector perdido se determino que en el probablemente comenzaban los datos de una imagen

Con esta información se procedió extraer los datos de la imagen que se adicionaron al grupo de archivos potencialmente analizables.

12.-Identificación de archivos existentes.

La pestaña file analysis de la interfaz de autopsy lista los archivos contenidos en la imagen.

13.-Identificación de archivos protegidos.

Uno de los archivos identificado en el paso anterior estaba comprimido. Se procedió a tratar de accederlo pero aparentaba estar corrupto. A continuación se noto, por medio de la lista de sectores asignados, que el tamaño notificado por la metadata del archivo (file analysis-metadata) no coincidía con el número de sectores continuos asignados. Por lo anterior hubo que extraerlo en su totalidad por medio de dcat, logrando recuperarlo mas no accederlo ya que este estaba protegido con contraseña, por esta razón fue incluido en los archivos sospechosos

14.-Consolidación de archivos potencialmente analizables.

Tomando como base los archivos encontrados durante las fases anteriores se procede a realizar una agrupación de los archivos que se analizaran durante el proceso.

15.-Determinación del sistema operativo y las aplicaciones instaladas.

Debido a que se está trabajando sobre la imagen del disquete, no e requiere hacer este paso

16.-Filtrado basado en archivos bueno conocidos.

Debido al reducido número de archivos comprometidos en la investigación los dos últimos pasos obviados en el proceso.

17.-Consolidación de archivos sospechosos

Para este caso, este conjunto equivale al de los archivos potencialmente analizables

18.-Primera clasificación

Se encontró una inconsciencia entre el contenido de un archivo y su extensión, el cual tendrá una máxima prioridad al momento de realiza el análisis

19.-Segunda clasificación.

No fue posible determinar una relación entre los archivos y el usuario, debido al que sistema de archivos particular no mantiene este tipo de información. A su vez se determino que todos los archivos encontrados tienen alta prioridad

20.-Analizar los archivos.

A la hora de de analizar los archivos, se encontró un documento que proveía información sobre el proveedor del inculpado. Además referencia a la existencia de un archivo que contenía la contraseña del archivo protegido

Se tomo la imagen y se procedió a buscaren en la firma de los archivos de terminación JPEG la cual se hallo por medio de la aplicación grep sobre el volcado hexadecimal de dichos archivos.

21.-Archivos comprometidos con el caso.

Este grupo de archivos es igual al de los archivos sospechosos, mas el archivo de Excel que logro ser accedido dentro del archivo comprimido.

22.-Obtención de la línea de tiempo definitiva

Dado que la información de tiempo de los archivos no estaba disponible, no fue posible desarrollar este pasó de la metodología.

Extraído del libro: COMPUTACIÓN FORENSE,descubriendo los rastros informáticos.

Autor: Jeimy J. Cano M.

Paginas:205-211.